AMD a officialisé le lancement de sa puce d’intelligence artificielle MI300X, qu’elle présente comme l’accélérateur d'IA le plus avancé de l'industrie, détrônant ainsi le Nvidia H100.

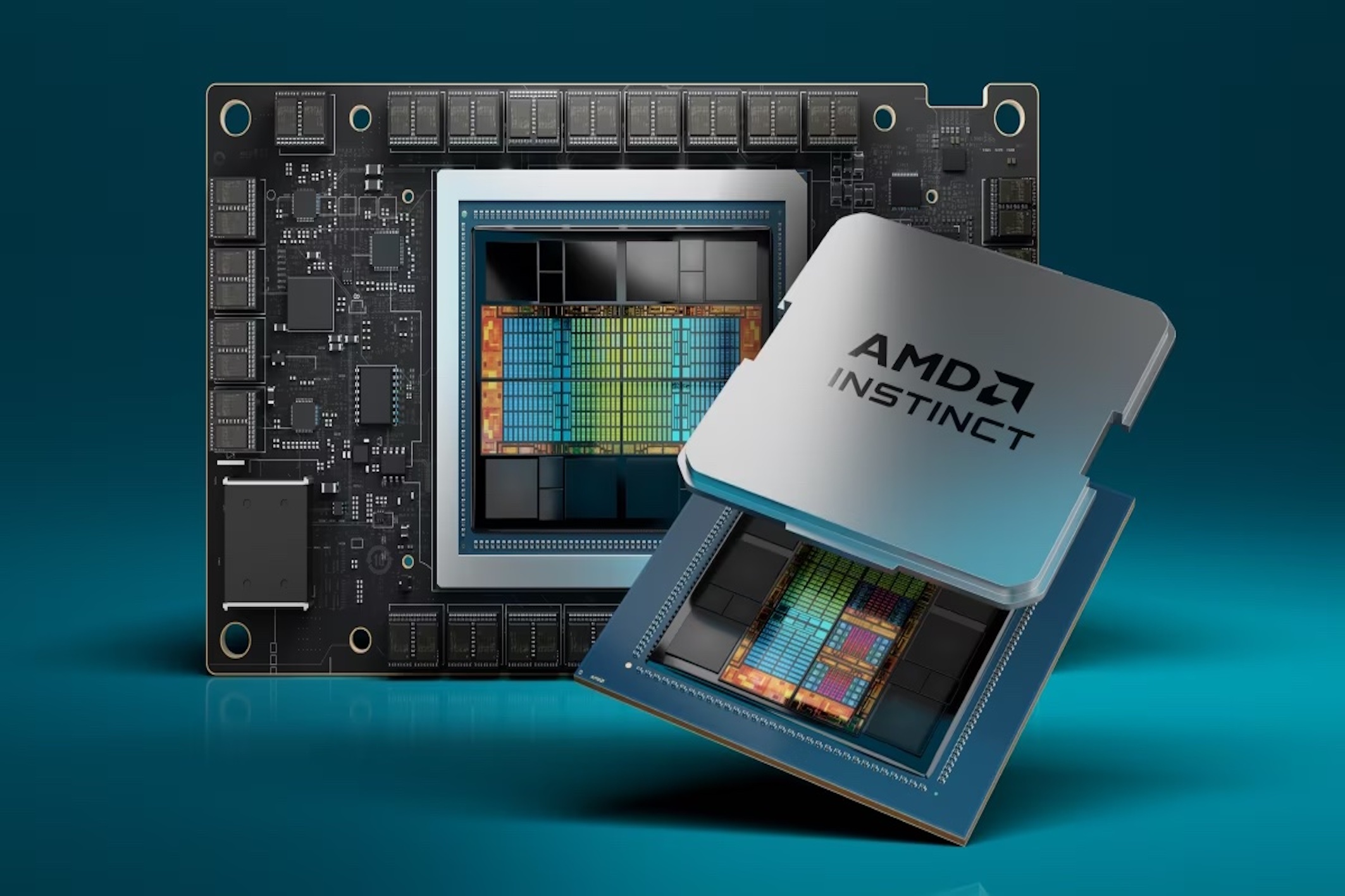

NVidia par-ci, Nvidia par-là, difficile de passer à côté du géant fabricant d’unités de traitement graphique (GPU) lorsqu’il est question de puces d’Intelligence Artificielle (IA). Et pourtant, celui qui s’est accaparé près de 90 % des parts de marché va devoir faire un peu de place à AMD qui a commercialisé, mercredi 6 décembre, sa première carte graphique conçue pour l’IA : la MI300X. Dans le même temps, AMD a également dévoilé une pile logicielle ouverte ROCm™ 6 avec des optimisations et de nouvelles fonctionnalités prenant en charge les grands modèles linguistiques (LLM) et les processeurs Ryzen™ série 8040 avec Ryzen AI.

Déjà de grands noms clients

« Nous constatons une très forte demande pour nos nouveaux GPU Instinct MI300, qui sont les accélérateurs les plus performants au monde pour l’IA générative. » a déclaré, confiante, la PDG de l’entreprise, Dr Lisa Su. Présentée lors de son événement, Advancing AI, MI300X par rapport au Nvidia H100 HGX, « peut offrir une augmentation de débit jusqu'à 1,6 fois lors de l'exécution d'inférence sur des LLM comme BLOOM 176B4 et est la seule option sur le marché capable d'exécuter une inférence pour un modèle de paramètres 70B, comme Llama2. », promet AMD dans son communiqué.

En parlant de Llama, le fabricant de semi-conducteur a également dévoilé plusieurs clients et pas des moindres, puisqu’il s’agit de Meta donc, mais aussi d’Oracle, de Microsoft, ou encore de Dell. La firme de Redmond va par exemple déployer les accélérations AMD Instinct MI300X afin d’alimenter ses machines virtuelles (VM) Azure ND MI300x v5 optimisées pour les charges de travail d'IA. Meta va quant à lui ajouter des accélérateurs AMD Instinct MI300X à ses centres de données en combinaison avec ROCm 6 pour alimenter les charges de travail d'inférence d'IA entre autres. Oracle souhaite proposer des solutions de calcul dans Oracle Cloud Infrastructure (OCI) comprenant les accélérations AMD Instinct MI300X. L’entreprise ambitionne également d’intégrer les accélérateurs dans son prochain service d'IA générative.

AMD veut répondre à la tension du marché

Depuis l’avènement de l’IA générative en novembre dernier, et le lancement de ChatGPT, la demande en GPU a explosé. Si bien que le marché est confronté à ses limites. Les délais de livraison des GPU H100 et A100 de Nvidia ont explosé, et le carnet de commandes est plein jusqu'à fin 2024. La chaîne d'approvisionnement est largement perturbée, et le risque d'une pénurie de GPU est bien réel, puisque Nvidia fournit actuellement entre 80 et 90 % de ceux qui sont spécifiquement adaptés aux applications d'IA. Cette tension laisse entrevoir une opportunité pour la concurrence qui pourrait plus facilement accaparer des parts de marché. Et ça, AMD l’a bien compris.